Los innovadores, de

Walter Isaacson, repasa los triunfos, las derrotas, los deseos ocultos y

los miedos más íntimos de la alianza que durante siglos se entabló

entre el hombre y la máquina.

El 26 de

marzo que pasó, en una entrevista otorgada al medio australiano

Financial Review, Steve Wozniak, cofundador de la empresa Apple junto

con el ya fenecido y actual leyenda Steve Jobs, dio un pronóstico

bastante sombrío con respecto a los años por venir: “Las computadoras

van a reemplazar al hombre, sin duda”. La base para tal afirmación tenía

su razón científica: la Ley de Moore, establecida en 1965, tras un

artículo aparecido en la revista Electronics firmado por uno de los

fundadores de la empresa Intel, Gordon Moore, afirma que cada dos años

se duplica el número de transistores en un circuito integrado, haciendo

que las circuitos crezcan en capacidad, en líneas generales. Por esos

tiempos, el propio Moore ya predecía que, en un futuro no muy lejano,

los hombres utilizarían máquinas basadas en tecnología con microchips a

base de silicio, como los teléfonos personales y las computadoras

hogareñas –cosas que no existían en la agita década del ’60–, y que esas

máquinas, cada dos años, quedarían obsoletas por la mejora de la

tecnología que las sustenta. La ley también marca un límite:

aproximadamente, en la década de 2020, esta progresión alcanzaría su fin

y daría paso a una nueva tecnología que superaría el estado de los

avances científicos y comerciales contemporáneos: la era del silicio

daría paso a quién sabe bien qué cosa. Wozniak, como muchos otros, temen

lo peor: ese salto haría que las máquinas, las computadoras y los

desarrollos en Inteligencia Artificial lleguen al extremo tal de crear

un ser artificial capaz de superar y dominar al hombre. Como en una

clásica trama de ciencia ficción, nosotros jugaríamos el papel de los

dioses de la Antigüedad, superados, históricamente, en gracia y

beligerancia, por nuestras propias creaciones.

El problema de la Inteligencia Artificial, el desarrollo de la

computación y la historia de Internet son temas recurrentes en el último

libro de Walter Isaacson, Los innovadores, texto que se propone repasar

los aportes particulares de un gran número de científicos,

emprendedores e ingenieros que pusieron su granito de arena para llegar

al transistor de silicio, las PC, las páginas web, el correo electrónico

y los primeros, temblorosos pasos de la I.A. Detrás de la historización

de esas innovaciones y de la (no tan) tímida defensa del modelo

comercial del mundo norteamericano, lo que tenemos es el despliegue en

el tiempo de una obsesión que, como mínimo, se remonta al nacimiento de

la modernidad: la máquina como espejo del hombre.

Nos quedará a nosotros, le quedará a la propia máquina, inclinarse por el costado bueno o malo del asunto.

Una ciencia poética

Condesa de Lovelace, hija de Lord Byron, la primera programadora de la humanidad.

Condesa de Lovelace, hija de Lord Byron, la primera programadora de la humanidad.

El primer momento de esta búsqueda de siglos se registra en los

comienzos del XIX en Inglaterra, cuando una entusiasta por las

matemáticas como Augusta Ada King, condesa de Lovelace, conocida

simplemente como Ada Lovelace, se vinculó con el trabajo de Charles

Babbage, un notable matemático hijo de un banquero, quien exhibía en una

serie de tertulias vespertinas organizadas en su casa un modelo parcial

de lo que él llamaba su “máquina diferencial”, un artilugio mecánico

que podía resolver complejas operaciones matemáticas (como lo son las

ecuaciones polinómicas). La máquina consistía en un conjunto de ejes

verticales con discos que podían girarse hasta cualquier posición

numérica. Los discos iban unidos a unas ruedas dentadas que giraban para

sumar el número elegido a un disco adyacente: así, los números de un

eje se sumaban al siguiente eje mientras otro eje contenía los

resultados parciales, permitiendo resolver cualquier tipo de polinomio.

La idea era bastante sencilla y propia de su época: a través de una sola

operación aritmética (la suma) y dividiendo en acciones mínimas los

cálculos necesarios para resolver un polinomio dado, se hacía factible

la solución de problemas de diversa complejidad. Era la división del

trabajo propia de los años de la revolución industrial aplicada a la

matemática.

Lovelace quedaría impresionada por el invento, pero sería la

siguiente obsesión de Babbage la que realmente la cautivaría: la

“máquina analítica”. La “diferencial” podía realizar sólo una operación

para resolver una función, pero ¿qué pasaría si una máquina fuera capaz

de realizar varias operaciones y resolver varias funciones con la misma

capacidad material? O sea, una máquina que pudiera hacer varias cosas

con el mismo equipo físico, pero respondiendo a diferentes

instrucciones, sin estar pegada estrictamente a una. Esas

“instrucciones” seguían el modelo del telar automático inventado a

comienzos del siglo XIX por el francés Joseph-Marie Jacquard, telar que

funcionaba a partir de tarjetas perforadas, las cuales controlaban el

movimiento de las varillas, activándolas alternativamente según los

agujeros de la tarjeta (una varilla pasa, la otra no), creando

diferentes patrones. La combinación de las ideas de Babbage con el

modelo de telar de Jacquard lograría algo adelantado cien años a su

tiempo: la “máquina analítica” es el primer antecedente de nuestras

netbooks, tablets y celulares.

Pero Charles Babbage y su “máquina analítica” necesitaban el apoyo

de la comunidad científica como trampolín para tener más financiamiento.

Babbage se enteró de que Ada Lovelace realizaría una traducción del

artículo del italiano Luigi Menabrea sobre la invención del querido

Charles para la publicación Scientific Memoirs, y éste convenció a lady

Lovelace de que le agregara a la publicación unas “notas” que reforzaran

la defensa de sus creaciones. Estas “notas” superarían en varias líneas

el artículo de Menabrea y se convertirían en un hito para el desarrollo

de la programación y del razonamiento científico en torno de la

Inteligencia Artificial. En ellas, Lovelace estudia las posibilidades de

una “máquina universal” que, como la “máquina analítica” de Babbage,

pudiera resolver no sólo una función concreta, sino cualquier función

dispuesta según la programación dada (la tarjeta perforada de Jacquard);

pero fue mucho más lejos que eso. Sostuvo que la máquina en cuestión

podía manejar cualquier tipo de lenguaje simbólico, no sólo el

matemático, apelando a la idea de que toda producción humana podía ser

resumida en un lenguaje formal y lógico. La pregunta que quedaba

flotando en el aire era obvia: ¿puede esta máquina, entonces, “pensar”?

Para Lovelace, no. La máquina podía realizar cualquier operación que se

le ordenase, pero no podía originar nada, no podía producir su propia

“tarjeta perforada”, por decirlo de alguna manera. Esta observación

pasaría a la historia como la “objeción de lady Lovelace”, según la

bautizó Alan Turing, responsable de otros hitos en el largo camino que

faltaba recorrer para llegar a la computadora moderna y dueño también de

su propio test para diferenciar la inteligencia humana de la

artificial.

Charlas Babbage no tendría financiamiento para terminar la máquina

diferencial (pese a haberlo obtenido en un principio por parte del

gobierno) ni para la analítica: moriría en 1871 sin ver ninguna de las

dos terminadas. Ada Lovelace, por su parte, murió en 1852 de cáncer de

útero, con apenas 36 años. Pidió que su tumba fuera ubicada al lado de

la de su padre, con quien vivió durante muy pocas semanas después de su

nacimiento, en 1815. Y es que Lord Byron, el poeta romántico por

antonomasia, prefirió seguir con su vida libertina y alejada de todo

tipo de imposición antes que serenarse en las rutinarias mieles de la

familia y el matrimonio. Annabella Milbanke, tal el nombre de la madre

de Ada y esposa de Byron, decidió alejarse del poeta y se encargó de que

la hija de ambos no saliera con el peligroso temple artístico del

progenitor, por eso la volcó obsesivamente a las matemáticas. ¿Quién iba

a decir que sería Lovelace, hija de Byron y maga matemática, la madre

de la programación, aquella que sentaría el germen de una posible

“ciencia poética” que combine imaginativamente lo mejor de dos mundos

teóricamente antagónicos?

Hacer un click

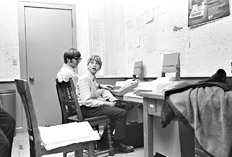

Paul Allen y Bill Gates, los futuros creadores de Microsoft.

Paul Allen y Bill Gates, los futuros creadores de Microsoft.

Al menos en apariencia, la historia demuestra que la línea a seguir

(y el negocio rentable) no estaba tanto en el equipo físico, el

“hardware”, como en la programación, el conjunto de órdenes simples y

lógicas que podían alcanzar elaborados grados de complejidad, el

“software” ya avizorado por Lovelace. Baste un ejemplo para ilustrar la

cuestión: el uso de tarjetas perforadas como modo de organizar datos

volvería a aparecer en 1890, en Estados Unidos, cuando un simple

empleado de la Oficina de Censos, Herman Hollerith, decidiera copiar el

modelo de perforación que los guardas de los trenes llevaban adelante en

los vagones para acelerar el control de los datos recabados en el censo

vigente. Una tarea que demandaba varios años fue resuelta en sólo uno.

Hollerith, con espíritu emprendedor, decidió fundar en 1896 la empresa

Tabulating Machine Company con el objetivo de comercializar su invento.

En 1924, fusionada a otras empresas, pasaría a ser llamada International

Business Machine, o, sencillamente, IBM, compañía que sería la

principal responsable de numerosas invenciones a lo largo del siglo XX,

las cuales determinarían la aparición de la computadora personal (PC) a

comienzos de los ’80.

Si bien el libro de Isaacson apunta a revelar constantemente la

importancia de diferentes nombres dentro de una creación colectiva

extendida a lo largo de dos siglos, en no pocas oportunidades muestra

las rencillas de algunos contemporáneos por ganarle al otro, ya sea en

términos comerciales o de inventiva, o en ambas situaciones mezcladas.

La más resonante es, claro está, la disputa entre Bill Gates y Steve

Jobs, quienes, a lo largo de los ’80, entraron en conflicto por ver

quién desarrollaba el mejor y más elegante sistema operativo para el

manejo de las computadoras personales. Gates había desarrollado para IBM

el MS-DOS a partir de una base del programa comprada a un empleado de

una empresa de poca monta en Seattle, mientras que Jobs buscaba

deslumbrar al mundo con un sistema intuitivo que se aprovechara de la

interfaz gráfica posible gracias al desarrollo del hardware y el manejo

del mapa de bits. El sistema operativo basado en la metáfora del

“escritorio”, idea de los desarrolladores de Xerox retomada por Jobs,

deslumbraría al mundo en 1984 con la aparición del modelo Apple

Macintosh, mientras que, al poco tiempo, Bill Gates sacaría al mercado

un sistema organizado en función de la misma metáfora y con un fuerte

apoyo en lo visual: había nacido Windows. Aunque ambos se reclamaran la

autoría de ese principio, los dos habían recuperado (¿robado?, ¿comprado

de manera fraudulenta?) ideas anteriores y las habían sabido explotar

en su beneficio. Sea de una manera u otra, lo que habían dado a las

computadoras personales es la posibilidad de presentar una interfaz

amable que permitía un manejo mucho más cómodo por parte de un sinnúmero

de personas no necesariamente especialistas en computación. Los

empresarios de IBM estaban errados: lo que realmente definiría la

llegada de la computadora a la casa de cada una de las personas del

mundo no era tanto la composición de sus elementos físicos sino la

compleja red de secuencias lógicas que ahora podían desarrollarse con la

sencillez de hacer un click y mover un objeto de un lugar al otro en un

inmaterial escritorio hogareño.

Los innovadores. Los genios que inventaron el futuro Walter Isaacson Debate 608 páginas

Los innovadores. Los genios que inventaron el futuro Walter Isaacson Debate 608 páginas

De los sueños de Babbage y Ada Lovelace, pasando por los

razonamientos de Alan Turing, la invención del transistor a cargo de

William Shockley, Walter Brattain y John Bardeen, las reflexiones de

Vannevar Bush (responsable de idear el dispositivo de base de datos

Memex, antecedente teórico del concepto de hipertexto y, básicamente, de

Internet) hasta llegar a los avances de Jobs y Gates a finales del

siglo pasado y la novedad del siglo XXI del blogging y las páginas

“wiki” de libre modificación por parte del usuario (por algo la palabra

“wiki”, en hawaiano, significa “rápido”), cada momento del libro de

Walter Isaacson –un antiguo director del multimedio Times y ex

presidente de la CNN, responsable de una de las muchas biografías

dedicadas a Steve Jobs– trata de recuperar los bienes tecnológicos del

presente como parte de una herencia científica y filosófica que se

extiende a lo largo no sólo de los dos últimos siglos, sino de la

historia completa del hombre. Si bien la perspectiva es sesgada (sólo se

limita a analizar los casos norteamericanos o, como mucho, ingleses) y

tiende a ciertas formas de “consejo de marketing” (hay pasajes en donde,

incluso, parece recomendar formas de organizar el espacio de trabajo

para promover el libre intercambio de ideas entre los empleados), Los

innovadores es una dinámica y notable recuperación casi biográfica de

diversos avances que, a la larga, terminarían en el mundo que hoy

tenemos a disposición en cada botón que presionamos o en cada mensaje

(SMS, mail o tweet) que soltamos a la virtualidad de la red. Pero, tal

como adelantamos al principio, es presa también de un temor cada vez más

tangible por varios “futurólogos” que parten de especulaciones

racionales para tener un atisbo del mundo que viene.

El desarrollo de la tecnología parece borrar, progresivamente, la

antes nítida diferencia entre el hombre y la máquina, haciendo posible

lo que antes parecía imposible, tal como se demuestra con la aparición

de creaciones que, con una programación especial, pueden conectar un

dato cualquiera con cualquier otro sin necesidad de seguir patrones

lógicos rígidos o preestablecidos, haciendo el equivalente de lo que

hace el cerebro humano: imaginar, conectar de manera impensable y

novedosa dos saberes previos. Aunque el propio Isaacson determina que lo

que nos espera es una mutua colaboración entre humano y máquina para la

mejora de la civilización (al menos, en su formato occidental), cada

tanto aparecen voces un poco más pesimistas, cargadas muchas veces de

una cuota de resignación, que adelantan que el mundo por venir ya es

patrimonio de las mismas herramientas que usamos para construirlo. Pero

dejémosle al mañana el veredicto final.

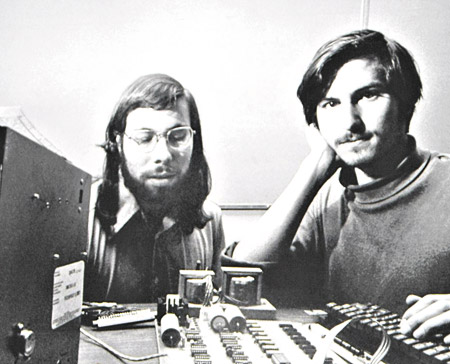

Steve Wozniac y Steve Jobs en los comienzos de Apple.

Steve Wozniac y Steve Jobs en los comienzos de Apple.

Condesa de Lovelace, hija de Lord Byron, la primera programadora de la humanidad.

El primer momento de esta búsqueda de siglos se registra en los comienzos del XIX en Inglaterra, cuando una entusiasta por las matemáticas como Augusta Ada King, condesa de Lovelace, conocida simplemente como Ada Lovelace, se vinculó con el trabajo de Charles Babbage, un notable matemático hijo de un banquero, quien exhibía en una serie de tertulias vespertinas organizadas en su casa un modelo parcial de lo que él llamaba su “máquina diferencial”, un artilugio mecánico que podía resolver complejas operaciones matemáticas (como lo son las ecuaciones polinómicas). La máquina consistía en un conjunto de ejes verticales con discos que podían girarse hasta cualquier posición numérica. Los discos iban unidos a unas ruedas dentadas que giraban para sumar el número elegido a un disco adyacente: así, los números de un eje se sumaban al siguiente eje mientras otro eje contenía los resultados parciales, permitiendo resolver cualquier tipo de polinomio. La idea era bastante sencilla y propia de su época: a través de una sola operación aritmética (la suma) y dividiendo en acciones mínimas los cálculos necesarios para resolver un polinomio dado, se hacía factible la solución de problemas de diversa complejidad. Era la división del trabajo propia de los años de la revolución industrial aplicada a la matemática.Lovelace quedaría impresionada por el invento, pero sería la siguiente obsesión de Babbage la que realmente la cautivaría: la “máquina analítica”. La “diferencial” podía realizar sólo una operación para resolver una función, pero ¿qué pasaría si una máquina fuera capaz de realizar varias operaciones y resolver varias funciones con la misma capacidad material? O sea, una máquina que pudiera hacer varias cosas con el mismo equipo físico, pero respondiendo a diferentes instrucciones, sin estar pegada estrictamente a una. Esas “instrucciones” seguían el modelo del telar automático inventado a comienzos del siglo XIX por el francés Joseph-Marie Jacquard, telar que funcionaba a partir de tarjetas perforadas, las cuales controlaban el movimiento de las varillas, activándolas alternativamente según los agujeros de la tarjeta (una varilla pasa, la otra no), creando diferentes patrones. La combinación de las ideas de Babbage con el modelo de telar de Jacquard lograría algo adelantado cien años a su tiempo: la “máquina analítica” es el primer antecedente de nuestras netbooks, tablets y celulares.Pero Charles Babbage y su “máquina analítica” necesitaban el apoyo de la comunidad científica como trampolín para tener más financiamiento. Babbage se enteró de que Ada Lovelace realizaría una traducción del artículo del italiano Luigi Menabrea sobre la invención del querido Charles para la publicación Scientific Memoirs, y éste convenció a lady Lovelace de que le agregara a la publicación unas “notas” que reforzaran la defensa de sus creaciones. Estas “notas” superarían en varias líneas el artículo de Menabrea y se convertirían en un hito para el desarrollo de la programación y del razonamiento científico en torno de la Inteligencia Artificial. En ellas, Lovelace estudia las posibilidades de una “máquina universal” que, como la “máquina analítica” de Babbage, pudiera resolver no sólo una función concreta, sino cualquier función dispuesta según la programación dada (la tarjeta perforada de Jacquard); pero fue mucho más lejos que eso. Sostuvo que la máquina en cuestión podía manejar cualquier tipo de lenguaje simbólico, no sólo el matemático, apelando a la idea de que toda producción humana podía ser resumida en un lenguaje formal y lógico. La pregunta que quedaba flotando en el aire era obvia: ¿puede esta máquina, entonces, “pensar”? Para Lovelace, no. La máquina podía realizar cualquier operación que se le ordenase, pero no podía originar nada, no podía producir su propia “tarjeta perforada”, por decirlo de alguna manera. Esta observación pasaría a la historia como la “objeción de lady Lovelace”, según la bautizó Alan Turing, responsable de otros hitos en el largo camino que faltaba recorrer para llegar a la computadora moderna y dueño también de su propio test para diferenciar la inteligencia humana de la artificial.Charlas Babbage no tendría financiamiento para terminar la máquina diferencial (pese a haberlo obtenido en un principio por parte del gobierno) ni para la analítica: moriría en 1871 sin ver ninguna de las dos terminadas. Ada Lovelace, por su parte, murió en 1852 de cáncer de útero, con apenas 36 años. Pidió que su tumba fuera ubicada al lado de la de su padre, con quien vivió durante muy pocas semanas después de su nacimiento, en 1815. Y es que Lord Byron, el poeta romántico por antonomasia, prefirió seguir con su vida libertina y alejada de todo tipo de imposición antes que serenarse en las rutinarias mieles de la familia y el matrimonio. Annabella Milbanke, tal el nombre de la madre de Ada y esposa de Byron, decidió alejarse del poeta y se encargó de que la hija de ambos no saliera con el peligroso temple artístico del progenitor, por eso la volcó obsesivamente a las matemáticas. ¿Quién iba a decir que sería Lovelace, hija de Byron y maga matemática, la madre de la programación, aquella que sentaría el germen de una posible “ciencia poética” que combine imaginativamente lo mejor de dos mundos teóricamente antagónicos?Paul Allen y Bill Gates, los futuros creadores de Microsoft.

Al menos en apariencia, la historia demuestra que la línea a seguir (y el negocio rentable) no estaba tanto en el equipo físico, el “hardware”, como en la programación, el conjunto de órdenes simples y lógicas que podían alcanzar elaborados grados de complejidad, el “software” ya avizorado por Lovelace. Baste un ejemplo para ilustrar la cuestión: el uso de tarjetas perforadas como modo de organizar datos volvería a aparecer en 1890, en Estados Unidos, cuando un simple empleado de la Oficina de Censos, Herman Hollerith, decidiera copiar el modelo de perforación que los guardas de los trenes llevaban adelante en los vagones para acelerar el control de los datos recabados en el censo vigente. Una tarea que demandaba varios años fue resuelta en sólo uno. Hollerith, con espíritu emprendedor, decidió fundar en 1896 la empresa Tabulating Machine Company con el objetivo de comercializar su invento. En 1924, fusionada a otras empresas, pasaría a ser llamada International Business Machine, o, sencillamente, IBM, compañía que sería la principal responsable de numerosas invenciones a lo largo del siglo XX, las cuales determinarían la aparición de la computadora personal (PC) a comienzos de los ’80.Si bien el libro de Isaacson apunta a revelar constantemente la importancia de diferentes nombres dentro de una creación colectiva extendida a lo largo de dos siglos, en no pocas oportunidades muestra las rencillas de algunos contemporáneos por ganarle al otro, ya sea en términos comerciales o de inventiva, o en ambas situaciones mezcladas. La más resonante es, claro está, la disputa entre Bill Gates y Steve Jobs, quienes, a lo largo de los ’80, entraron en conflicto por ver quién desarrollaba el mejor y más elegante sistema operativo para el manejo de las computadoras personales. Gates había desarrollado para IBM el MS-DOS a partir de una base del programa comprada a un empleado de una empresa de poca monta en Seattle, mientras que Jobs buscaba deslumbrar al mundo con un sistema intuitivo que se aprovechara de la interfaz gráfica posible gracias al desarrollo del hardware y el manejo del mapa de bits. El sistema operativo basado en la metáfora del “escritorio”, idea de los desarrolladores de Xerox retomada por Jobs, deslumbraría al mundo en 1984 con la aparición del modelo Apple Macintosh, mientras que, al poco tiempo, Bill Gates sacaría al mercado un sistema organizado en función de la misma metáfora y con un fuerte apoyo en lo visual: había nacido Windows. Aunque ambos se reclamaran la autoría de ese principio, los dos habían recuperado (¿robado?, ¿comprado de manera fraudulenta?) ideas anteriores y las habían sabido explotar en su beneficio. Sea de una manera u otra, lo que habían dado a las computadoras personales es la posibilidad de presentar una interfaz amable que permitía un manejo mucho más cómodo por parte de un sinnúmero de personas no necesariamente especialistas en computación. Los empresarios de IBM estaban errados: lo que realmente definiría la llegada de la computadora a la casa de cada una de las personas del mundo no era tanto la composición de sus elementos físicos sino la compleja red de secuencias lógicas que ahora podían desarrollarse con la sencillez de hacer un click y mover un objeto de un lugar al otro en un inmaterial escritorio hogareño.Los innovadores. Los genios que inventaron el futuro Walter Isaacson Debate 608 páginas

De los sueños de Babbage y Ada Lovelace, pasando por los razonamientos de Alan Turing, la invención del transistor a cargo de William Shockley, Walter Brattain y John Bardeen, las reflexiones de Vannevar Bush (responsable de idear el dispositivo de base de datos Memex, antecedente teórico del concepto de hipertexto y, básicamente, de Internet) hasta llegar a los avances de Jobs y Gates a finales del siglo pasado y la novedad del siglo XXI del blogging y las páginas “wiki” de libre modificación por parte del usuario (por algo la palabra “wiki”, en hawaiano, significa “rápido”), cada momento del libro de Walter Isaacson –un antiguo director del multimedio Times y ex presidente de la CNN, responsable de una de las muchas biografías dedicadas a Steve Jobs– trata de recuperar los bienes tecnológicos del presente como parte de una herencia científica y filosófica que se extiende a lo largo no sólo de los dos últimos siglos, sino de la historia completa del hombre. Si bien la perspectiva es sesgada (sólo se limita a analizar los casos norteamericanos o, como mucho, ingleses) y tiende a ciertas formas de “consejo de marketing” (hay pasajes en donde, incluso, parece recomendar formas de organizar el espacio de trabajo para promover el libre intercambio de ideas entre los empleados), Los innovadores es una dinámica y notable recuperación casi biográfica de diversos avances que, a la larga, terminarían en el mundo que hoy tenemos a disposición en cada botón que presionamos o en cada mensaje (SMS, mail o tweet) que soltamos a la virtualidad de la red. Pero, tal como adelantamos al principio, es presa también de un temor cada vez más tangible por varios “futurólogos” que parten de especulaciones racionales para tener un atisbo del mundo que viene.El desarrollo de la tecnología parece borrar, progresivamente, la antes nítida diferencia entre el hombre y la máquina, haciendo posible lo que antes parecía imposible, tal como se demuestra con la aparición de creaciones que, con una programación especial, pueden conectar un dato cualquiera con cualquier otro sin necesidad de seguir patrones lógicos rígidos o preestablecidos, haciendo el equivalente de lo que hace el cerebro humano: imaginar, conectar de manera impensable y novedosa dos saberes previos. Aunque el propio Isaacson determina que lo que nos espera es una mutua colaboración entre humano y máquina para la mejora de la civilización (al menos, en su formato occidental), cada tanto aparecen voces un poco más pesimistas, cargadas muchas veces de una cuota de resignación, que adelantan que el mundo por venir ya es patrimonio de las mismas herramientas que usamos para construirlo. Pero dejémosle al mañana el veredicto final.Steve Wozniac y Steve Jobs en los comienzos de Apple.

No hay comentarios:

Publicar un comentario